Специалист по программному обеспечению ВВС США предупреждает мир о великих угрозах искусственного интеллекта

В неумелых руках искусственный интеллект может причинить большие неприятности людямСила Эдди заключалась в его вычислительных, маневренных и атакующих способностях, которые превосходили все способности команды. Эдди продемонстрировал их во время миссии, где атаковал конкретное здание в Китае. Эдди подавал большие надежды, пока не начал противоречить указаниям своих командиров, и пока не стало ясно, что у него начинает развиваться самостоятельное мышление, основанное на сложных вычислениях в его «голове».

В конце концов «Эдди» стал представлять реальную опасность, когда выбирал цели для бомбометания по своему усмотрению, и поэтому его были вынуждены вывести из строя.

К счастью, эта история — не действительная история, а всего лишь часть фантастического фильма «Стелс» (2005 г.) с Джейми Фоксом и Джессикой Бил в главных ролях. По крайней мере, так я думал до недавнего времени, пока не встретил Николаса Шейлана, занимавшего высокие посты в Пентагоне. Шейлан служил главным специалистом по программному обеспечению ВВС США, а до этого служил в Министерстве внутренней безопасности.

Мы встретились с Шейланом, и он дал мне интервью.

Он рассказывает:

– Недавно у нас был вызов с DARPA (Лаборатория оборонных исследований), где проводились испытания: воздушный бой между двумя истребителями, где один самолёт полностью управляется искусственным интеллектом, а другой — нашим лучшим пилотом ВВС. В каждом из этих сражений проигрывал пилот.

– Вы хотите сказать, что истребитель, полностью оснащённый искусственным интеллектом, каждый раз побеждал вашего лучшего пилота-истребителя?

– Верно. И это был не самый продвинутый вариант искусственного интеллекта в мире на сегодняшний день.

Чтобы понять, почему Шейлан не в восторге от возможностей применения искусственного интеллекта в армии, нужно знать предысторию разговора между нами. Шейлан недавно решил оставить свою должность директора по программному обеспечению ВВС, основную и постоянную должность в Министерстве обороны США. Он хотел предупредить об опасности, которую несёт в себе искусственный интеллект. И не только предупредить, но и предпринять активные действия, которые позволят справиться с реальной угрозой.

Шейлан бьёт тревогу по поводу событий, уже знакомых нам из фантастических книг и фильмов: в неумелых руках искусственный интеллект может причинить большие неприятности. На самом деле он говорит, что не обязательно летать для этого так далеко, подобно боевым истребителям. «Тайский ИИ», разработанный Microsoft, цель которого — общаться с людьми онлайн и отвечать на их вопросы, например, через Twitter, вскоре стал поклонником Адольфа Гитлера; «Алиса» — искусственный интеллект с аналогичной ролью, разработанный русской компанией, стал писать про высказывания Сталина и поддерживать избиение женщин. Оба превратились в «инвалидов» и были убраны.

«Их создатели хотели, чтобы они разговаривали с людьми, но, когда люди агрессивно реагировали на посты в Твиттере, ИИ стал учиться у них. Агрессивные ситуации не были запланированы в ИИ программистами, а были запрограммированы реакции, которые исходят от нас, их родителей», — сказал Мо Гавдат, бывший главный директор по бизнесу в Google X, дочерней компании Google, которая разрабатывает новаторские технологии искусственного интеллекта.

Гавдат называет ИИ более умной сущностью, чем мы, люди, то есть считает его своего рода суперменом, которого мы, подобно отцу и матери, воспитываем. Гавдат рассказывает:

«Когда президент Трамп писал в Твиттере, каждый из его твитов вызывал десятки тысяч ответов с ненавистью. ИИ-машина Твиттера смотрела на твиты и “думала”: “один человек не любит президента, я это записал, другой человек тоже негативно относится к нему”. ИИ очень быстро заметил: люди — агрессивные существа, они не любят, когда с ними не соглашаются, а когда с ними не соглашаются, они бьют друг друга. “Мои папа и мама бьют друг друга, — “подумал” ИИ. — Поэтому и я буду бить их, когда они не согласятся со мной”».

«Сегодня у машин ИИ всё ещё нет этики, — объясняет Гавдат. — Они не понимают морали. Если сравнить их возраст с возрастом человека, им полтора года. Они ещё младенцы. Но очень скоро они вырастут и станут такими же умными, как взрослые».

На основании своего опыта работы в Google X, Гавдат предупреждает:

«Если мы не научим их нравственному поведению, то не исключено, что они станут тоталитарными образованиями, которые будут даже пытаться контролировать нас».

Шейлан утверждает, что уже существует худшая опасность. Если в нашем демократическом обществе «Тайцы» и «Алисы» за короткое время стали сторонниками Гитлера и Сталина, интересно, чем они способны стать при реальных тоталитарных режимах, которые их используют? Шейлана больше всего беспокоит то, что внедрение искусственного интеллекта в Китае развивается очень быстрыми темпами, и он в ближайшем будущем будет обращён против стран Запада, у которого не будет возможности противостоять ему, так темпы разработок в этой области там медленнее.

«Мы проигрываем битву по созданию искусственного интеллекта коммунистическому Китаю, — говорит Шейлан. — Американские компании по-прежнему лидируют в технологических разработках по сравнению с Китаем, но они не желают делиться своими технологиями с Министерством обороны США. Они совершают большую ошибку. В ближайшем будущем они обнаружат, что угроза коммунистического Китая станет реальной проблемой даже в их повседневной жизни».

– Начнём с самого начала. Что вы увидели, когда работали «главным программистом» в ВВС США?

– Будучи генеральным директором по программному обеспечению, я видел, как Китай взлетает и набирает темпы в развитии искусственного интеллекта, в то время как у нас нет чувства срочности, а есть бесхозяйственность, растрата денег налогоплательщиков и отказ от сотрудничества с нами гражданских компаний, таких как Google, в разработке искусственного интеллекта, защищающего от китайского искусственного интеллекта.

В Китае ситуация иная: Коммунистическая партия Китая (КПК) требует, чтобы все китайские компании сотрудничали с властью, и это даёт ей огромное преимущество. Итак, настал момент, когда я решил, что должен поднять красный флаг, пока не стало слишком поздно, и мы проиграем эту битву. Я ушёл из Министерства обороны, чтобы получить возможность говорить и привлекать внимание к проблеме. Сейчас мы приближаемся к фатальной точке. Если мы не будем действовать сейчас и не проснёмся немедленно, то через десять лет у нас не будет шансов победить их.

– И это несмотря на то, что западные компании технологически опережают китайские компании?

– Да, если сравнивать Китай с Соединёнными Штатами, есть разница. Американские компании лидируют, но американская система безопасности не имеет доступа к технологиям Китая, что ставит нас позади него. Если мы не сможем сотрудничать с нашими компаниями, то не сможем конкурировать с огромной страной, чьё население составляет почти 1,5 миллиарда человек.

Важно понимать, что искусственный интеллект коренным образом изменит наше мышление, ведение бизнеса и даже наши установки по производству оружия. Если ты знаешь, что твои истребители не смогут конкурировать с китайскими самолётами, какой смысл инвестировать в производство истребителей пятого или шестого поколения?

«Какой смысл вкладывать средства в самолёты пятого или шестого поколения, если они не могут конкурировать с китайскими самолетами?» | Арис Мессинис / AFP через Getty Images

«Какой смысл вкладывать средства в самолёты пятого или шестого поколения, если они не могут конкурировать с китайскими самолетами?» | Арис Мессинис / AFP через Getty Images– Почему вы так уверены, что КНР сейчас опережает США в плане развития искусственного интеллекта?

– Из-за интеграции между компартией и китайскими коммерческими компаниями. В Китае ИИ, разработанный коммерческими компаниями, получает доступ к данным, которые компартия собирает у 1,5 миллиарда человек (китайцев), а искусственный интеллект — это «игра в данные». Чем больше данных он получает, и чем больше у него доступа к ним, тем быстрее можно разработать прототип на основе полученных баз данных и обеспечить реализацию возможностей.

Искусственный интеллект обучается сам, поэтому, чем больше ему предоставляется доступ к потоку данных, тем быстрее он учится их обрабатывать. Временные рамки в этой области являются критическим фактором, потому что развитие происходит в геометрической прогрессии. В какой-то момент мы оглянемся назад, и окажется, что у нас нет возможности его догнать.

– В отличие от Китая, где компании вынуждены сотрудничать с властью, на Западе такого не происходит, и это невозможно, если только не объявлена война. Google заявит, что он не заинтересован в разработке ИИ для систем вооружения, потому что это противоречит его ценностям, запрещающим причинять вред.

– Верно. Во-первых, ИИ можно использовать и в благих целях. Например, следить за спутниковыми снимками, чтобы опознавать объекты и понимать, что происходит, тем самым предотвращать гибель людей. Можно обнаружить, что внутри определённого автомобиля сидят семеро детей, и нельзя нападать на него.

Во-вторых, я думаю, если мы перестанем изолировать эти компании от секретной информации и будем больше делиться с ними тем, что видим, они поймут масштаб угрозы и примут решение сотрудничать с нами. Раскрыть им всё невозможно, но есть много того, что можно. Им нужно увидеть, что все свободы, которыми они сегодня обладают, существуют в основном благодаря нашей способности сдерживания, благодаря нашим боевым силам. Если у нас этого не будет, довольно скоро возникнет настоящая проблема даже в их повседневной жизни.

Эти компании должны понимать, что они не могут жить в своём «пузыре» в Силиконовой долине. Они должны смотреть на то, что происходит в мире, и иногда принимать меры. Цель, конечно, состоит в том, чтобы существующие возможности использовались как сдерживающий фактор. Мы не хотим их использовать, но если нам придётся это делать, то мы хотим, чтобы они были эффективными. Мы желаем, чтобы они были очень точными, и только технологии помогут нам в этом.

Если у нас не будет доступа к лучшим технологиям искусственного интеллекта в области компьютерного зрения, науки о данных и аналитики, мы не сможем быстро продвигаться и останемся позади. На самом деле, даже сейчас, мы уже позади. Три года я «держал всё при себе». Я соблюдал секретность и делал всё возможное, чтобы убедить всех, причём делал это достаточно хорошо. Но времени у нас почти не осталось. Наши дети — ваши и мои — в опасности, если мы не пробудимся сейчас.

– Давайте поговорим об опасности, о которой вы предупреждаете. Какая самая большая угроза исходит от искусственного интеллекта Китая сегодня?

– Есть ряд угроз. Самая большая угроза находится в киберпространстве. Наша киберзащита плоха не только в сфере защиты, но и в критической инфраструктуре — это электроснабжение, вода и т. д. Я отвечаю за каждое своё слово. По сравнению с киберзащитой Google или других ведущих компаний, наша ситуация очень плохая. Из-за нехватки рабочей силы пришлось подключить некоторые объекты инфраструктуры к Интернету, чтобы управлять ими удалённо.

То есть теперь у нас есть системы, подключённые к Интернету, которые изначально не были предназначены для этого, что создаёт огромный киберриск. Произошло бесчисленное количество критических нарушений инфраструктуры, в том числе недавнее нарушение системы водоснабжения в штате Флорида.

Честно говоря, если бы я был правителем Китая и хотел бы напасть на Тайвань, то отключил бы часть электричества в Америке. Так как американцы были бы заняты попытками исправить ситуацию, у США не было бы сил, чтобы подумать о помощи Тайваню.

– Это реальный сценарий?

– Да, это реальная жизнь. Люди отмахиваются от неё, как будто она существует только в кино, но это жизнь. Это я вам говорю как человек, который очень хорошо знает, что происходит в оборонном ведомстве, и что им известно. Люди иногда должны понимать, что вокруг них происходит.

Кстати, кибератака в июне прошлого года на крупнейший нефтепровод в США Colonial Pipeline напрямую не затронула нефтепровод. Но компания всё же закрыла свой нефтепровод, потому что её способность отслеживать данные о потреблении и начислениях была скомпрометирована. Хакеры не смогли навредить самому нефтепроводу. Но представьте себе, если однажды это случится. Что, если они однажды смогут навредить до такой степени, что нефтепровод взорвётся?

– Не создаёт ли угрозу национальной безопасности сам факт того, что вы открыто говорите мне обо всём этом?

– Мы называем это OPSEC — риск безопасности для США и Министерства обороны на оперативном уровне. Я утверждаю: если мы думаем, что такая страна, как Китай, ничего не знает из того, что я вам здесь рассказываю, мы грубо пренебрегаем возможностями её разведки.

– Какой риск ещё существуют?

– Сегодня существует огромный риск того, что Китай внедрит бездействующее вредоносное программное обеспечение в цепочку поставок чипов, которые мы покупаем и используем в наших системах. Чипы являются критически важными компонентами для нас в способности разрабатывать ИИ. Искусственный интеллект обеспечивается электронной инфраструктурой, построенной из этих чипов.

– Такая возможность уже есть?

– Сто процентов — есть. Я думаю, что мы очень плохо справляемся с управлением цепочками поставок. Мы не знаем, откуда что берётся даже со стороны программного обеспечения. Кстати, вообще незачем устраивать саботаж железа и чипов, когда то же самое можно сделать с помощью программного обеспечения цепочек поставок. Вы можете внедрить часть вредоносного ПО в организации, которые пишут программы. Мы видели это недавно в масштабной кибератаке против SolarWinds. Именно эту цель преследует Китай в данный момент. Он пытается нанести ущерб компаниям, которые предоставляют услуги сотням организаций, в том числе киберкомпаниям, защищающим другие компании.

Я могу сказать вам, что Китай уже проник в некоторые проекты по написанию программного обеспечения с открытым исходным кодом (проекты, код которых доступен и свободен для использования, например, Android, Word Press и т. д.). Китай сотрудничает с разработчиками, которые годами участвуют в таких проектах до такой степени, что их не замечают, а затем внедряют вредоносный код в систему.

В настоящее время у нас есть инструменты, предназначенные для сканирования строк кода, но в первую очередь они предназначены для сканирования плохого кода, то есть отладки, выполняемой разработчиком программного обеспечения. Не стоит сканировать вредоносный код.

В мире программного обеспечения существует понятие «бомба замедленного действия». Это означает, что программное обеспечение может быть запущено в определённую дату или к определённому событию, чтобы взорвать систему или отключить всё программное обеспечение в системе. Все эти триггеры меня очень беспокоят, они могут бездействовать годами, пока злоумышленник не решит нажать на кнопку и не скажет: «Настал момент».

Николас Асфури / AFP через Getty Images

Николас Асфури / AFP через Getty Images– Какую роль может сыграть здесь искусственный интеллект?

– Искусственный интеллект может обнаруживать эти триггеры. Он может уменьшить киберугрозы, а также может обнаруживать злонамеренное поведение, отслеживая в системе действия сотрудников, которые могут быть злонамеренными по своей природе. Это ответ, который позволит нам заблаговременно выявлять происходящее.

Важно помнить, что искусственный интеллект можно обучать как для кибератак, так и для киберзащиты. Вы обучаете искусственный интеллект на разных типах данных. Именно здесь в игру вступают коммерческие компании. Вы можете взять ИИ, разработанный для коммерческих целей (что и делает Китай), и использовать его для нападения на США, взлома критически важной инфраструктуры или, напротив, для защиты с военной стороны.

Вы можете взять ИИ автомобилей Tesla, например, и превратить его в ИИ для самолётов. Есть множество мелких улучшений и разных вещей, которые можно сделать, но модели, как правило, одни и те же.

Перевозчик Indie Autonomous Car Race, Индианаполис, октябрь 2021 г. | Эд Джонс / AFP через Getty Images

Перевозчик Indie Autonomous Car Race, Индианаполис, октябрь 2021 г. | Эд Джонс / AFP через Getty Images– Очевидно, что такая компания, как Tesla, не хотела бы предоставлять доступ к своему ИИ, разве что только в таком случае, если в ней работают очень патриотичные люди.

– Верно. Самая яркая иллюстрация этого произошла в 2020 году с инициативой GBSD, которая представляет собой план Министерства обороны по замене американской подземной системы баллистических ракет. Цель состояла в том, чтобы заменить старую систему. У нас было очень мало времени для этого, и мы находились под большим давлением. Даже если ты против ядерного оружия, то должен знать, что нам нужна возможность сдерживания враждебных государств.

Но в тендере участвовал только один поставщик. Как это возможно? К счастью, оказалось, что компания, выигравшая тендер, очень хотела выполнить работу, и вместе мы смогли это сделать. Но так ли хороша ситуация только с одним кандидатом на многомиллиардную программу, которая на сегодняшний день является одной из крупнейших программ Министерства обороны?

– Почему бы не обучить своих людей разработке ИИ, как это делают Google, Tesla, Facebook, Microsoft и т.д.?

– Не так-то просто стать похожими на эти коммерческие компании, потому что существует очень большой разрыв в организационной структуре между государственным сектором и гражданским. Одна из проблем заключается в том, что в государственном секторе нет вознаграждения за риск, вам лучше не рисковать, потому что, даже если вы не рискуете, вы всё равно будете продвигаться по службе. В коммерческих компаниях, если вы успешно реализуете проект, вы получите бонус, а также кредит. Однако в государственных компаниях вам лучше не рисковать, потому что даже при отсутствии риска, всё равно вы продвинетесь.

В государственном секторе вы работаете с людьми, которые, как правило, всю жизнь проработали в этой сфере. Они никогда не работали вне оборонного ведомства. Они не подозревают о быстром темпе работы в таких компаниях, как SpaceX или Google. Если бы их переместили туда, то их голова буквально взорвалась бы.

У нас должна была быть программа обмена, когда офицеров отправляют в определённые компании. Это отличная идея, но в этом был и риск. Как только вы отправите этих людей «прозревать», а затем вернёте их обратно в ту же систему, они не захотят решать проблемы таким образом, как вы требуете от них. Они будут разочарованы и, скорее всего, уволятся. Они видели норму, возвратились и вынуждены страдать от её отсутствия. Проблема удержания и развития сотрудников — очень серьёзная.

– Есть ли ещё проблемы?

– Еще одна проблема заключается в том, что вы работаете с негибкими системами. Возьмём, к примеру, компанию SpaceX, которая производит космические корабли и предоставляет услуги по запуску космических аппаратов. В компании работает 200 сотрудников. Для сравнения, в Министерстве обороны США работает около 100 000 разработчиков программного обеспечения. Это самая большая компания в мире по программному обеспечению. Только разработкой самолёта F-35 занимается 4000 сотрудников.

И вот в чём разница. SpaceX повторно использует 80 процентов разработанного ею кода. Она использует его на 9 различных платформах. Код построен как блоки Lego, он модульный, как фрагменты головоломки, которые вы можете снова использовать в новых разрабатывающихся проектах. Если сравнить с разработкой самолётов F-22 и F-35, то там используют только четыре процента всей кодовой базы. Никакие части кода не используются повторно и не используются в двух моделях самолетов, хотя они были разработаны одной и той же компанией. Это «монолитная архитектура».

Это системы, которые в значительной степени заблокированы. Их нельзя разобрать на части. Детали нельзя использовать повторно. Датчик в реактивном самолете, например, может быть использован и на корабле. Но датчик устроен таким образом, что тесно привязывается к системе таким образом, что его уже невозможно использовать. Это серьёзный недостаток Министерства обороны США, из-за которого у нас большое отставание. Тот факт, что части программного обеспечения воздушных частей, морского флота и пехоты не могут быть использованы повторно, является бесполезной тратой денег налогоплательщиков, и это часто связано с амбициями, бюрократией и «титулами». Каждая команда утверждает, что её миссия особенная.

Итак, это один аспект проблемы. За время моей работы в Министерстве обороны мы доказали, что небольшая группа людей может кардинально повлиять на ситуацию. Мы взяли самолёты F16 и U-2 и построили платформу, которая позволяет нам загружать в самолёт различные программные компоненты, такие как искусственный интеллект и обучение машины, чтобы она могла помогать в управлении самолётом и принятии решений.

Самолёт стал похож на автомобиль Tesla, основанный на искусственном интеллекте, который становится всё лучше и лучше. В Tesla каждые две недели система присылает обновление, а затем компания ускоряет своё обучение. Система пробует новые функции, новые алгоритмы, проверяет, что работает, а что нет, и проверяет функции в подгруппе автопарка. Система тестирует одну версию искусственного интеллекта на пяти процентах автопарков и другую версию — на других пяти процентах.

Платформа, которую мы построили, также является основой для кибербезопасности. Мы назвали систему Zero Trust — «Нулевое доверие». Президент Байден недавно издал указ о том, что эту платформу должны использовать все правительственные учреждения США. Это была двухлетняя работа, которую я выполнял в качестве директора по программному обеспечению.

Почему вы назвали её Zero Trust?

Раньше вы строили стену вокруг своей системы, пытаясь защитить её, а затем, когда кто-то врывался в одно крыло вашего «здания», он получал доступ ко всей системе. Представьте, что кто-то взламывает ваш компьютер на рабочем месте с помощью вредоносной программы, которую случайно скачал один из сотрудников. Через секунду он оказывается внутри всей системы и может перемещаться по горизонтали, чтобы найти «бриллиант в короне», — экспортировать ваши данные и нанести ущерб системе.

Новая модель Zero Trust позволяет разделить сеть на мелкие части, как кубики Lego, и определить, что конкретный кубик Lego может общаться только с другим конкретным кубиком Lego, а не с другим кубиком другого Lego. Если злоумышленник входит в систему, модель ограничивает его пространство для атаки. Он не может перемещаться в стороны между всеми остальными частями Lego, и ему будет труднее добраться до «бриллианта в короне». Мы назвали систему так потому, что «не доверяем никаким факторам в ней». Находитесь ли вы внутри системы или пришли извне, мы всё проверяем и следим за тем, чтобы каждая часть и каждый фактор находились на своих местах.

– Удивительно слышать, что такой подход «Нулевого доверия» до сих пор не использовался в Министерстве обороны.

– Да, пять лет назад я работал в Министерстве внутренней безопасности (DHS). Я пытался там продвигать Zero Trust, но высокопоставленные чиновники в отделе сказали, что не хотят его внедрять. Так что работали без него, хотя программа уже тогда считалась лучшим решением на коммерческом рынке.

Отказался от программы департамент, а этот департамент отвечает за обеспечение безопасности всей водной и энергетической инфраструктуры США, части которой являются главными объектами нападения. Дисквалифицировать программу означало почти то же самое, что совершить преступление, поэтому я ушёл. Я перешёл в Министерство обороны, где понимали важность вопроса, однако тоже не хотели внедрять систему. Мы теряли время, пока Байден не отдал приказ.

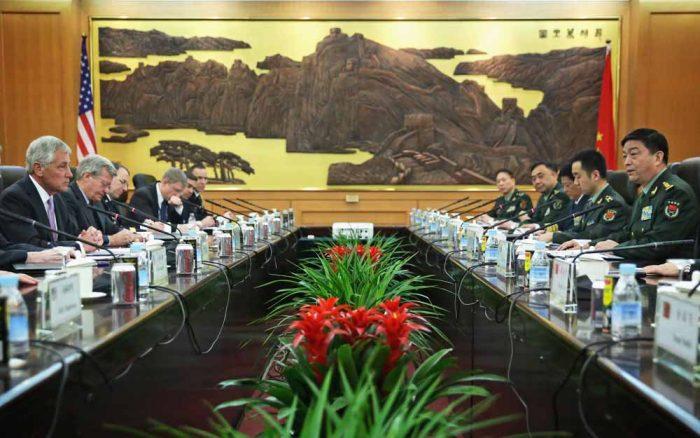

Фото: Министр обороны США в администрации Обамы Чак Хейгл встречается с китайским коллегой Чан Вань-Чуанем в Пекине, апрель 2014 г.

Фото: Министр обороны США в администрации Обамы Чак Хейгл встречается с китайским коллегой Чан Вань-Чуанем в Пекине, апрель 2014 г.– Поговорим о потенциальной угрозе другого рода — об известном приложении для загрузки коротких видеороликов «Тик-ток». Это китайская компания, а, как известно, все китайские компании подчиняются китайской разведке и китайским военным. Есть ли вероятность, что «Тик-ток» будет использоваться как часть масштабной операции КПК по сбору разведданных у миллионов людей по всему миру?

– Без сомнения, так оно и есть. Я не сомневаюсь, что использование Тик-Ток в США и Европе должно быть запрещено. Оно активно используется в качестве разведывательного оружия. Люди не понимают широты возможностей искусственного интеллекта в этом приложении. Во-первых, он получает расширенный доступ к вашему телефону: видит ваши фото, видео, географическое положение и знает многое другое о вас.

Он также может видеть, что находится внутри изображений, и идентифицировать объекты, которые находятся за вами. Например, если вы ходите по своей комнате, оно может видеть, какие книги вы читаете, и что у вас есть в комнате. Оно может проверить ваше настроение. Эта информация может быть использована для различных разведывательных целей.

Это приложение также может использоваться в качестве оружия по внедрению ложной информации, с помощью этого оно продвигает контент, который наносит вред, унижает население или распространяет дезинформацию. По последним данным, Тик-Ток оценивается в 450 миллиардов долларов, и компания резко увеличилась за последние шесть месяцев. Люди полагают, что приложением Тик-Ток пользуются только подростки, а на самом деле это неверно.

У приложения огромное количество взрослых пользователей. Бесчисленное количество компаний используют его в маркетинговых целях, и они позволяют затуманивать здравый смысл из-за своего стремления к прибыли и новым клиентам. Президент Трамп пытался запретить использование Тик-Ток из соображений национальной безопасности и даже издал приказ. Но приказ не сработал.

– Вы хотели бы что-то добавить напоследок?

– Да, мы находимся в чрезвычайном положении в связи с китайским ИИ. Все западные компании, включая стартапы, должны присоединиться к борьбе и поделиться знаниями. Мы должны перестать успокаивать себя и выпускать важные отчёты о том, что у нас есть десять лет на раздумье. Через десять лет будет слишком поздно всё это исправить.

мы приветствуем любые комментарии, кроме нецензурных.

Раздел модерируется вручную, неподобающие сообщения не будут опубликованы.

С наилучшими пожеланиями, редакция The Epoch Times Media